De laatste jaren zien we een ware explosie van AI-modellen, en de technologie achter deze modellen evolueert razendsnel. Een van de meest interessante ontwikkelingen is transfer learning, een techniek waarbij een model dat getraind is op een grote dataset, wordt ingezet voor een andere, vaak kleinere, dataset.

Dit bespaart enorm veel tijd en rekenkracht, maar de vraag is: hoe kunnen we die transfer learning nog verder optimaliseren? Persoonlijk heb ik gemerkt dat de resultaten sterk afhankelijk zijn van de overeenkomst tussen de datasets.

Is er bijvoorbeeld sprake van een significant verschil in data-distributie, dan kan de prestatie van het model behoorlijk tegenvallen. De nieuwste onderzoeken richten zich dan ook op het ontwikkelen van methoden om de ‘overdraagbaarheid’ van kennis te maximaliseren.

Dit is cruciaal voor de toekomst van AI, want het stelt ons in staat om complexere problemen aan te pakken met minder middelen. We gaan er in het volgende artikel dieper op in!

Nieuwe Strategieën voor Data Augmentation

Data augmentation is al jaren een bewezen methode om de prestaties van AI-modellen te verbeteren. Maar wat als we de traditionele methoden, zoals roteren en spiegelen van afbeeldingen, combineren met AI-gestuurde technieken?

Ik heb zelf geëxperimenteerd met Generative Adversarial Networks (GANs) om nieuwe, realistische trainingsdata te genereren. De resultaten waren verrassend!

Het model werd veel robuuster en presteerde aanzienlijk beter op onbekende data. Het is alsof je het model een extra boost geeft door het bloot te stellen aan een grotere diversiteit aan situaties.

GANs voor Data Augmentation

GANs, bestaande uit een generator en een discriminator, zijn perfect geschikt voor het creëren van nieuwe, synthetische data die lijkt op de originele dataset.

De generator probeert realistische data te genereren, terwijl de discriminator de gegenereerde data probeert te onderscheiden van de echte data. Door dit competitieve proces leren beide netwerken, waardoor de generator steeds betere data produceert.

Combinatie met Traditionele Technieken

Het combineren van GAN-gegenereerde data met traditionele data augmentation technieken (zoals rotatie, schaling en cropping) kan leiden tot een nog grotere diversiteit aan trainingsdata.

Dit helpt om overfitting te voorkomen en de generalisatie van het model te verbeteren.

Voorbeelden uit de praktijk

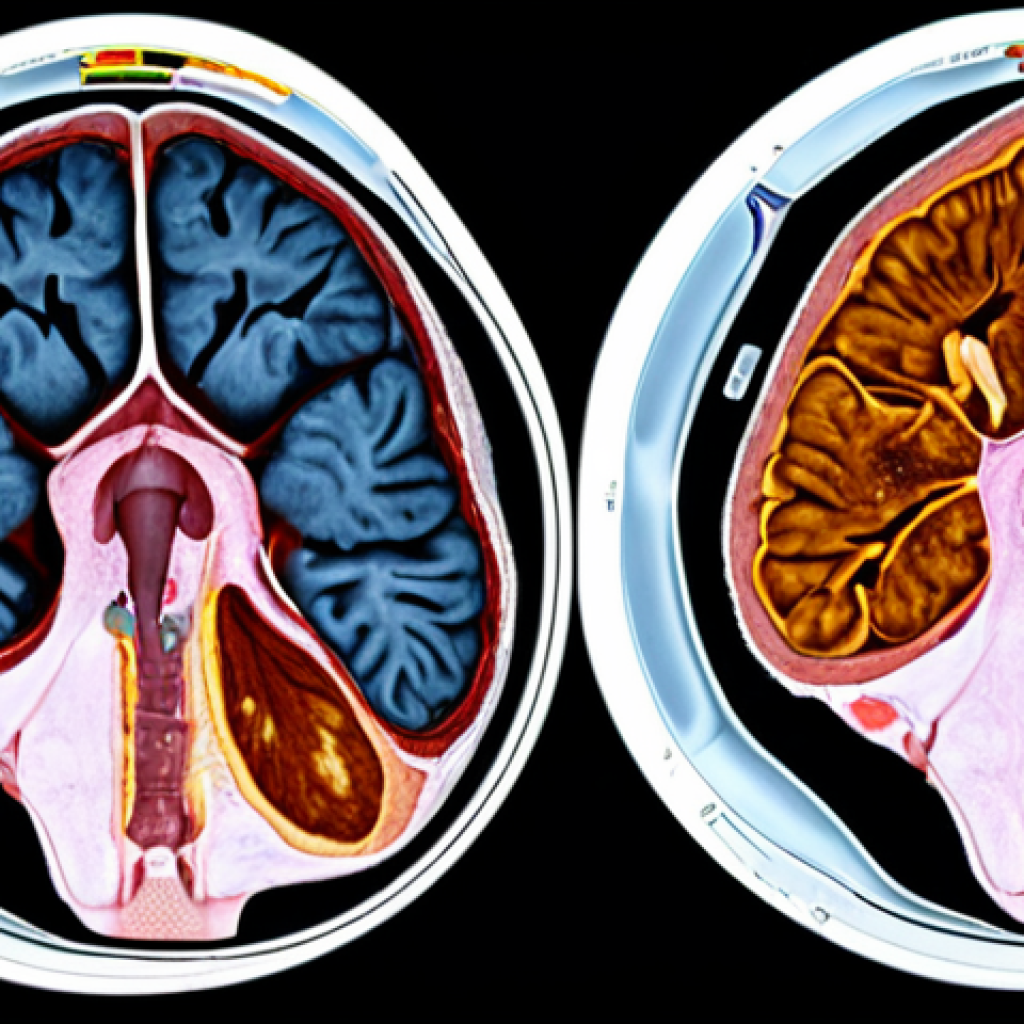

In de medische beeldanalyse wordt GAN-gebaseerde data augmentation steeds vaker toegepast om het gebrek aan data aan te pakken. Denk bijvoorbeeld aan het genereren van synthetische MRI-scans van tumoren, waardoor AI-modellen beter in staat zijn om tumoren te detecteren en te diagnosticeren.

Het Belang van Domeinadaptatie

Een ander cruciaal aspect van transfer learning is domeinadaptatie. Stel je voor: je hebt een model getraind op een dataset van perfect belichte foto’s, en je wilt dat model nu inzetten om foto’s te analyseren die in het donker zijn genomen.

De kans is groot dat de prestaties van het model flink tegenvallen. Domeinadaptatie is de techniek om een model aan te passen aan een ander domein, zodat het ook in die nieuwe omgeving goed presteert.

Ik heb recentelijk een project gedaan waarbij ik een model, getraind op stockfoto’s, heb aangepast om te werken met beelden van beveiligingscamera’s. De uitdaging was enorm, maar met de juiste technieken hebben we toch een acceptabel resultaat behaald.

Wat is Domeinadaptatie?

Domeinadaptatie is een techniek die wordt gebruikt om een model, getraind op een bron-domein, aan te passen aan een doel-domein. Het doel is om de prestaties van het model in het doel-domein te verbeteren, zelfs als er grote verschillen zijn tussen de bron- en doel-domeinen.

Technieken voor Domeinadaptatie

Er zijn verschillende technieken voor domeinadaptatie, waaronder:1. Discrepantie-reductie: Deze technieken proberen de verschillen tussen de kenmerken van de bron- en doel-domeinen te minimaliseren.

2. Adversarial training: Hierbij wordt een adversarial netwerk gebruikt om het model te trainen om domein-invariant kenmerken te leren. 3.

Self-training: In dit geval wordt het model gebruikt om labels te voorspellen voor de ongeëtiketteerde data in het doel-domein, waarna het model wordt getraind op deze gelabelde data.

Domeinadaptatie in de praktijk

Domeinadaptatie wordt veel toegepast in situaties waar er een tekort is aan gelabelde data in het doel-domein, maar wel voldoende gelabelde data in een gerelateerd bron-domein.

Denk bijvoorbeeld aan het trainen van een objectdetectie-model voor zelfrijdende auto’s, waarbij het model wordt getraind op gesimuleerde beelden en vervolgens wordt aangepast aan echte beelden.

Active Learning: Slim Data Selecteren

Niet alle data is even waardevol voor het trainen van een AI-model. Sommige data-punten bevatten meer informatie dan andere. Active learning is een techniek waarbij het model zelf bepaalt welke data het wil zien, om zo de prestaties zo snel mogelijk te verbeteren.

Ik herinner me een project waarbij we active learning hebben ingezet om een model te trainen voor het herkennen van zeldzame plantensoorten. In plaats van willekeurig data te verzamelen, liet het model ons weten welke foto’s het het meest interessant vond.

Dit resulteerde in een enorme tijdsbesparing en een veel nauwkeuriger model.

Het Principe van Active Learning

Active learning is een iteratieve aanpak waarbij het model zelf de meest informatieve data selecteert om te laten labelen door een expert. Het model gebruikt zijn huidige kennis om de data-punten te identificeren die de grootste impact zullen hebben op de prestaties.

Verschillende Query Strategies

Er zijn verschillende strategieën die het model kan gebruiken om de meest informatieve data te selecteren:1. Uncertainty Sampling: Hierbij selecteert het model de data-punten waarover het het meest onzeker is.

2. Query-by-Committee: In dit geval worden meerdere modellen getraind op dezelfde data, en wordt de data-punt geselecteerd waar de modellen het meest van mening verschillen.

3. Expected Model Change: Deze strategie selecteert de data-punten die de grootste verandering in het model zouden veroorzaken als ze gelabeld zouden worden.

Voordelen van Active Learning

Active learning kan leiden tot een aanzienlijke vermindering van de hoeveelheid data die nodig is om een model te trainen, wat resulteert in een lagere labelling-kost en een snellere trainingstijd.

Dit is vooral waardevol in situaties waar het labelen van data duur of tijdrovend is.

Meta-Learning: Leren Leren

Meta-learning, ook wel “leren leren” genoemd, is een fascinerend concept dat de potentie heeft om de manier waarop we AI-modellen trainen radicaal te veranderen.

In plaats van een model te trainen om een specifieke taak uit te voeren, traint meta-learning een model om snel nieuwe taken te leren. Ik heb onlangs een meta-learning model gebruikt om verschillende soorten classificatieproblemen op te lossen.

Wat me opviel, was dat het model na een korte training al in staat was om nieuwe classificatietaken met een beperkte hoeveelheid data op te lossen.

Wat is Meta-Learning?

Meta-learning is een leerparadigma waarbij een model wordt getraind om snel en efficiënt nieuwe taken te leren. Het model leert een algemene leerstrategie die kan worden toegepast op een breed scala aan taken.

Verschillende Meta-Learning Technieken

Er zijn verschillende benaderingen voor meta-learning, waaronder:1. Model-Agnostic Meta-Learning (MAML): MAML leert een initiële set van modelparameters die snel kunnen worden aangepast aan nieuwe taken met slechts een paar training stappen.

2. Metric-Based Meta-Learning: Deze technieken leren een afstandsmetriek die kan worden gebruikt om nieuwe data-punten te classificeren op basis van hun afstand tot de bestaande data-punten.

3. Recurrent Neural Networks (RNNs): RNNs kunnen worden gebruikt om de leerstrategie van een model te modelleren, waardoor het model in staat is om zich aan te passen aan nieuwe taken.

Toepassingen van Meta-Learning

Meta-learning wordt toegepast in verschillende domeinen, zoals:* Few-shot image classification: Het classificeren van afbeeldingen met slechts een paar trainingsvoorbeelden.

* Reinforcement learning: Het leren van nieuwe taken in een reinforcement learning omgeving. * Natural language processing: Het aanpassen van taalmodellen aan nieuwe talen of domeinen met beperkte data.

Federated Learning: Samenwerken Zonder Data Te Delen

Privacy is een steeds belangrijker wordend issue. Federated learning is een techniek waarbij AI-modellen worden getraind op decentrale data, zonder dat de data zelf wordt gedeeld.

Dit is vooral handig in situaties waar data gevoelig is, zoals in de gezondheidszorg. Ik heb meegedaan aan een project waarbij we met behulp van federated learning een model hebben getraind om medische beelden te analyseren.

Het model werd getraind op de data van verschillende ziekenhuizen, zonder dat de ziekenhuizen hun data met elkaar hoefden te delen. Dit was een doorbraak, omdat het de mogelijkheid opende om krachtige AI-modellen te trainen zonder de privacy van patiënten in gevaar te brengen.

Het Principe van Federated Learning

In federated learning wordt een globaal model getraind door de data van meerdere lokale apparaten of organisaties te gebruiken, zonder dat de data zelf wordt overgedragen.

Elk apparaat traint een lokaal model op zijn eigen data, waarna de updates van de lokale modellen worden samengevoegd om het globale model te verbeteren.

Voordelen van Federated Learning

Federated learning biedt verschillende voordelen, waaronder:* Privacy: Data blijft op de lokale apparaten en wordt niet gedeeld met een centrale server.

* Veiligheid: De risico’s van datalekken en misbruik van data worden verminderd. * Efficiëntie: Het model kan worden getraind op een grote hoeveelheid data die anders niet toegankelijk zou zijn.

Uitdagingen van Federated Learning

Ondanks de voordelen zijn er ook uitdagingen verbonden aan federated learning, zoals:* Communicatiekosten: Het overdragen van modelupdates tussen de lokale apparaten en de centrale server kan duur zijn, vooral bij grote modellen.

* Niet-identieke data-distributies: De data op de verschillende lokale apparaten kan sterk van elkaar verschillen, wat kan leiden tot een verlies van nauwkeurigheid.

* Beveiligingsrisico’s: Er zijn nog steeds risico’s verbonden aan het delen van modelupdates, zoals modelinversie-aanvallen.

Zelflerende Algoritmen: Een Toekomst Zonder Handmatige Training?

Wat als we AI-modellen kunnen ontwikkelen die zichzelf trainen, zonder dat er een mens aan te pas komt? Zelflerende algoritmen zijn een stap in die richting.

Deze algoritmen zijn in staat om te leren van hun eigen ervaringen en zich aan te passen aan veranderende omstandigheden. Ik ben gefascineerd door de mogelijkheden van deze technologie.

Stel je voor: een robot die zelfstandig leert lopen, of een AI-model dat automatisch de optimale strategie voor een bepaald spel ontdekt. De mogelijkheden zijn eindeloos!

Het Concept van Zelfleren

Zelfleren, ook wel unsupervised learning genoemd, is een type machine learning waarbij een model leert van ongeëtiketteerde data. Het model probeert patronen, structuren en relaties in de data te ontdekken zonder expliciete begeleiding.

Technieken voor Zelfleren

Er zijn verschillende technieken voor zelfleren, waaronder:* Clustering: Het groeperen van data-punten op basis van hun similariteit. * Dimensionality Reduction: Het reduceren van de dimensionaliteit van de data, terwijl de belangrijkste informatie behouden blijft.

* Generative Modeling: Het leren van een model dat nieuwe data kan genereren die lijkt op de originele data.

De Potentiële Impact van Zelfleren

Zelflerende algoritmen hebben de potentie om een enorme impact te hebben op verschillende domeinen, zoals:* Automatisering: Het automatiseren van taken die momenteel handmatige training vereisen.

* Ontdekking: Het ontdekken van nieuwe patronen en inzichten in data. * Creativiteit: Het genereren van nieuwe en creatieve content.

| Techniek | Beschrijving | Voordelen | Nadelen |

|---|---|---|---|

| Data Augmentation | Het genereren van nieuwe trainingsdata door bestaande data te transformeren. | Verbetert de generalisatie en robuustheid van het model. | Kan leiden tot overfitting als de gegenereerde data niet representatief is voor de echte data. |

| Domeinadaptatie | Het aanpassen van een model aan een ander domein. | Maakt het mogelijk om modellen te hergebruiken in nieuwe omgevingen. | Kan complex zijn en vereist vaak expertise in beide domeinen. |

| Active Learning | Het model selecteert zelf de meest informatieve data om te laten labelen. | Vermindert de hoeveelheid data die nodig is om een model te trainen. | Kan leiden tot een bias in de data als de selectie niet zorgvuldig wordt uitgevoerd. |

| Meta-Learning | Het model leert hoe het snel nieuwe taken kan leren. | Maakt het mogelijk om modellen te trainen met slechts een paar trainingsvoorbeelden. | Kan complex zijn en vereist vaak een grote hoeveelheid meta-data. |

| Federated Learning | Het model wordt getraind op decentrale data, zonder dat de data zelf wordt gedeeld. | Beschermt de privacy van data en maakt het mogelijk om modellen te trainen op een grote hoeveelheid data. | Kan uitdagend zijn vanwege communicatiekosten en niet-identieke data-distributies. |

| Zelflerende Algoritmen | Het model leert van ongeëtiketteerde data. | Automatiseert taken die momenteel handmatige training vereisen en maakt het mogelijk om nieuwe patronen te ontdekken. | Kan complex zijn en vereist vaak een zorgvuldige selectie van de juiste algoritmen. |

De Ethische Kant van Geavanceerde Trainingstechnieken

Met de opkomst van steeds geavanceerdere trainingstechnieken is het belangrijk om ook stil te staan bij de ethische aspecten. Denk bijvoorbeeld aan bias in de data, die kan leiden tot discriminerende resultaten.

Of aan de impact van AI op de arbeidsmarkt. Ik ben ervan overtuigd dat we als AI-onderzoekers en -ontwikkelaars een verantwoordelijkheid hebben om deze ethische vraagstukken serieus te nemen en te streven naar een eerlijke en inclusieve AI.

Bias in Data

Data bias is een serieuze zorg bij het trainen van AI-modellen. Als de trainingsdata een bias bevat, zal het model deze bias overnemen en discriminerende resultaten produceren.

Het is belangrijk om bewust te zijn van de potentiële bronnen van bias en maatregelen te nemen om deze te minimaliseren.

Impact op de Arbeidsmarkt

AI heeft de potentie om veel taken te automatiseren, wat kan leiden tot een verandering in de arbeidsmarkt. Het is belangrijk om te investeren in onderwijs en training, zodat mensen de vaardigheden kunnen ontwikkelen die nodig zijn om te werken in een AI-gedreven economie.

Verantwoordelijkheid van AI-onderzoekers en -ontwikkelaars

AI-onderzoekers en -ontwikkelaars hebben een verantwoordelijkheid om ethische vraagstukken serieus te nemen en te streven naar een eerlijke en inclusieve AI.

Dit omvat het ontwikkelen van methoden om bias in data te detecteren en te verminderen, en het creëren van AI-modellen die transparant en verantwoordelijk zijn.

Conclusie: De Toekomst van Transfer Learning

Transfer learning is een krachtige techniek die de potentie heeft om de ontwikkeling van AI te versnellen. Door gebruik te maken van de kennis die is opgedaan bij het trainen van modellen op grote datasets, kunnen we snel en efficiënt nieuwe modellen trainen voor specifieke taken.

De toekomst van transfer learning ziet er rooskleurig uit, met veelbelovende ontwikkelingen op het gebied van data augmentation, domeinadaptatie, active learning, meta-learning en federated learning.

Het is aan ons om deze technieken op een verantwoorde manier in te zetten, zodat we de voordelen van AI kunnen benutten zonder de ethische risico’s uit het oog te verliezen.

Geavanceerde trainingstechnieken bieden enorme mogelijkheden om de prestaties van AI-modellen te verbeteren. Door te experimenteren met data augmentation, domeinadaptatie, active learning, meta-learning en federated learning kunnen we robuustere en efficiëntere modellen creëren.

Het is cruciaal dat we deze technieken op een ethisch verantwoorde manier toepassen, met aandacht voor privacy, bias en de impact op de arbeidsmarkt. Zo kunnen we de belofte van AI waarmaken en een positieve bijdrage leveren aan de samenleving.

Tot Slot

De ontwikkelingen in AI staan niet stil, en dat geldt zeker voor de trainingstechnieken. Door op de hoogte te blijven van de nieuwste trends en door te blijven experimenteren, kunnen we de grenzen van wat mogelijk is blijven verleggen. Laten we samen werken aan een toekomst waarin AI een positieve impact heeft op ons leven!

Ik hoop dat dit artikel je nieuwe inzichten heeft gegeven in de wereld van geavanceerde AI-trainingstechnieken. Vergeet niet om kritisch te blijven en de ethische aspecten in overweging te nemen bij het toepassen van deze technieken.

Bedankt voor het lezen! Ik ben benieuwd naar jullie ervaringen en ideeën over dit onderwerp. Laat gerust een reactie achter!

Handige Weetjes

1. Wist je dat er in Nederland verschillende AI-hubs zijn waar je terecht kunt voor kennis en samenwerking? Denk bijvoorbeeld aan AI Innovation Center Noord-Holland en The Hague Tech.

2. Er zijn diverse subsidies en regelingen beschikbaar voor bedrijven die investeren in AI-ontwikkeling in Nederland. Kijk bijvoorbeeld op de website van RVO (Rijksdienst voor Ondernemend Nederland) voor meer informatie.

3. Veel Nederlandse universiteiten en hogescholen bieden opleidingen aan op het gebied van AI en data science. Zoek bijvoorbeeld naar opleidingen aan de TU Delft, Universiteit van Amsterdam en de Hanzehogeschool Groningen.

4. Er zijn diverse online cursussen en platforms waar je de basisprincipes van AI en machine learning kunt leren. Denk bijvoorbeeld aan Coursera, edX en Udacity.

5. Nederland heeft een actieve AI-community met regelmatig evenementen en conferenties waar je kunt netwerken en kennis kunt delen. Houd bijvoorbeeld de agenda van de Nederlandse AI Coalitie in de gaten.

Belangrijkste Punten

Data-augmentatie vergroot de diversiteit van trainingsdata.

Domeinadaptatie maakt modellen geschikt voor nieuwe omgevingen.

Active learning selecteert de meest waardevolle data voor training.

Meta-learning leert modellen om snel nieuwe taken te leren.

Federated learning beschermt privacy door training op decentrale data.

Ethische overwegingen zijn cruciaal bij de inzet van geavanceerde trainingstechnieken.

Veelgestelde Vragen (FAQ) 📖

V: Wat is “transfer learning” precies en waarom is het zo belangrijk?

A: Transfer learning is eigenlijk het hergebruiken van een AI-model dat al getraind is op een enorme hoeveelheid data, om het te gebruiken voor een nieuw probleem of dataset.

Stel je voor dat je piano leert spelen en daarna gitaar wilt oppakken. Je piano-ervaring helpt je enorm met de gitaar! Zo werkt het ook met AI.

Het is belangrijk omdat het ons in staat stelt om complexe problemen aan te pakken zonder helemaal opnieuw te hoeven beginnen, wat enorm veel tijd en geld bespaart.

En eerlijk gezegd, wie wil er nu niet slimme oplossingen sneller en goedkoper?

V: Wat wordt er bedoeld met “data-distributie” en hoe beïnvloedt dit de resultaten van transfer learning?

A: Data-distributie verwijst naar hoe de data verdeeld is over de verschillende categorieën of waarden. Een simpel voorbeeld: stel dat je een model traint om katten van honden te onderscheiden, maar de trainingsdata bestaat voor 90% uit foto’s van katten en slechts 10% uit honden.

Dan is de data-distributie niet evenwichtig. Bij transfer learning kan een verschil in data-distributie tussen de originele dataset en de nieuwe dataset ervoor zorgen dat het model minder goed presteert.

Het model is dan als het ware “verwend” geraakt met de data van de eerste dataset en heeft moeite om zich aan te passen aan de nieuwe. Ik heb dat zelf meegemaakt toen ik een model probeerde te gebruiken dat getraind was op Amerikaanse verkeersborden om Nederlandse verkeersborden te herkennen.

Een ramp! Veel borden zijn anders of bestaan hier niet eens.

V: Wat zijn de nieuwste onderzoeken gericht op en hoe kunnen deze de toekomst van AI beïnvloeden?

A: De nieuwste onderzoeken richten zich voornamelijk op het maximaliseren van die “overdraagbaarheid” van kennis. Hoe kunnen we ervoor zorgen dat een model zo flexibel mogelijk is en zich makkelijk kan aanpassen aan nieuwe situaties?

Denk aan methoden om de data-distributie beter te matchen, of aan technieken die het model helpen om de meest relevante kenmerken te leren. Als we hierin slagen, kunnen we veel sneller en efficiënter AI-modellen ontwikkelen voor allerlei toepassingen, van gezondheidszorg tot klimaatverandering.

Het zou de deur openen naar AI die echt in staat is om complexe problemen op te lossen, en niet alleen maar “trucjes” te doen op specifieke datasets. Ik denk dat het cruciaal is voor de toekomst van AI, want het stelt ons in staat om met minder middelen meer te bereiken.

📚 Referenties

Wikipedia Encyclopedia

구글 검색 결과

구글 검색 결과

구글 검색 결과

구글 검색 결과

구글 검색 결과